SEO 优化方式

- SEO

-

手动优化网站,长期做法;

- SEM

-

买排名,短期做法;

SEM 有见效快、范围广、操作简单、季节性优势;但有价格贵、波动大、恶意点击问题(模仿真实IP搜索点击指定竞价广告,让你造成预算快速消耗或广告提前下线)。

|

本文主要介绍 SEO

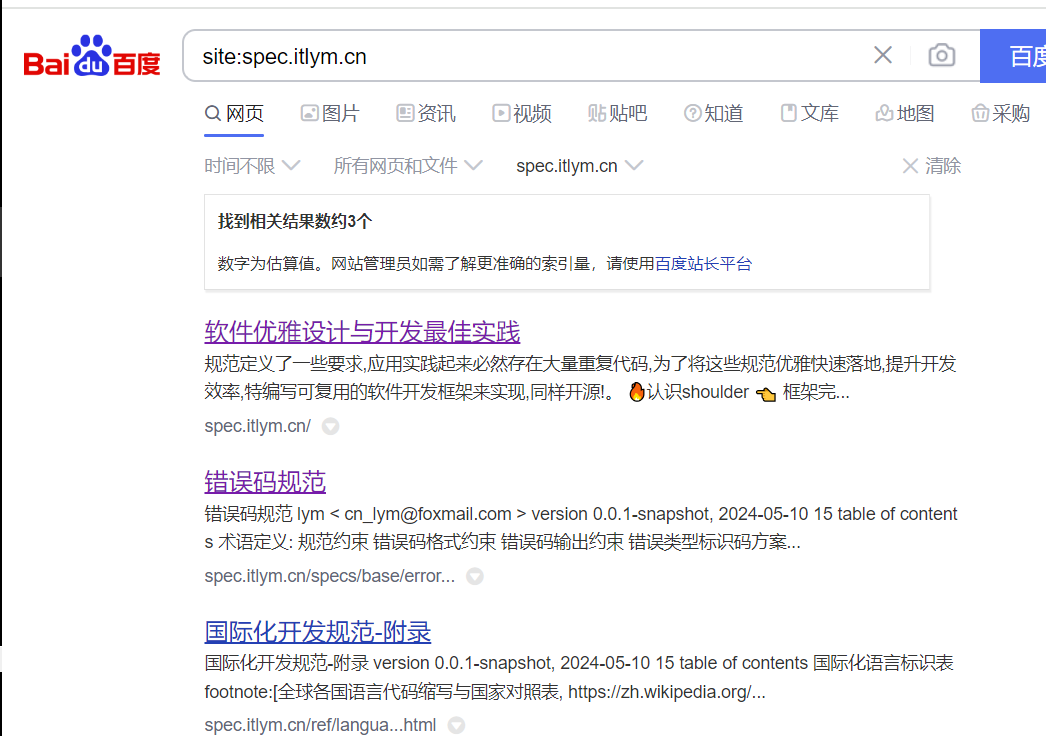

网站主动收录

-

sogou: http://fankui.help.sogou.com/index.php/web/web/index?type=1

-

Google:https://www.google.com/webmasters/tools/submit-url

-

bing:http://www.bing.com/toolbox/submit-site-url

-

神马:https://zhanzhang.sm.cn/

-

YANDEX

-

Ecosia

-

Yahoo

-

Naver

-

DuckDuckGo

1. 链接提交尽量全 2. 确认站点类型是否有移动端适配,建议自适应 3. 提交备案号 4. 大概提交一个月左右可能被收录

页面布局

HTML 代码注意

<h> 标签

-

h1-h6 依次减弱

-

h1 / h2 不建议在一个页面中同时使用

-

h1 / h2 建议包含关键词

-

h1 / h2 建议只出现一次

-

h3/4/5 不建议使用

-

h6 可用于友情链接,降低友情链接对页面关键词的影响

Nofollow

当超级链接中出现 nofollow 标签时,搜索引擎不考虑此链接的权重,也不参与排名

-

写在meta标签上,告诉爬虫不要抓取网页上的外部和内部链接;

<meta name="robots” content="nofollow” /> -

写在超链接a标签中,告诉爬虫不要抓取特定的链接,如

rel="external nofollow" -

网站链上垃圾网站会降低权限,对可以的第三方链接使用

nofollow标签 -

网站版权、备案、站外链接都应该加

nofollow标签

robots.txt

存放在根目录下的文本文件,告诉爬虫哪些内容可否索引,也可以将不希望爬虫索引的内容放进此文件

-

引导搜索引擎蜘蛛爬取

-

指定栏目或内容

-

抓取网站地图

-

重构目录改名,将旧的目录暂时屏蔽

-

-

屏蔽页面

-

死链、404错误页面

-

无意义无内容页面

-

重复页

-

不想被收录的页面

-

较大的文件,如图片、视频等节约宽带提升速度

-

Sitemaps

-

通知爬虫哪些网页是可以爬取的

-

此文件通常是

xml格式(较少为txt) -

每个网址包含一个父标记条目,一个子标记条目

-

网址应该以

http开头,少于2048个字符 -

可以通过各个站长平台提交,也可以将地址放在

robots.txt文件中;在robots.txt最后一行添加http://www.yours.com/sitemap.xml

URL 优化

常见 URL 不规范问题

-

同一页面链接不统一;

-

静态化

URL设置错误; -

静态和动态

URL共存; -

加密网址https和未加密网址http同时存在;

-

URL中有端口; -

在

URL后面添加跟踪代码,如trace,click跟踪;

最佳实践

-

链接保持统一

-

使用

canonical标签,解决多个不同URL可访问相同页面的问题,如/index.html和/指向相同文件 -

在

http://www.example.com/standerd?timestamp=12345里添加<link rel="canonical" href="http://www.example.com/standerd" /> -

注意添加的链接不要绑定端,避免

PC端关联到移动端情况 -

尽量使用

绝对链接,而非相对链接 -

一个页面中只设置一个

canonical标签 -

网站更换域名时,服务器不支持重定向的情况下,可以使用

canonical标签

-

-

制作

xml网站地图规范化网址,提交搜索引擎; -

301 重定向